Das Debüt von GPT-3 war ein Wendepunkt, nicht nur für die künstliche Intelligenz, sondern auch für unsere kollektive Vorstellungskraft darüber, was Technologie leisten kann. Es erweiterte unser Verständnis von Maschinen, die Daten blitzschnell verarbeiten oder komplexe Gleichungen lösen können. Heute können Sprachmodelle eine Erzählung erstellen, Humor in ein Gespräch bringen und im Wesentlichen die kreative Kraft des menschlichen Geistes nachahmen. Die Nuancen menschlicher Emotionen, des Humors und des Denkens in Binärcode zu übersetzen, blieb jedoch ein Rätsel. Hier kommt das bestärkende Lernen mit menschlichem Feedback (RLHF) ins Spiel, ein bahnbrechender Ansatz, der uns der Lösung dieses Rätsels näher bringen wird.

Bei RLHF geht es darum, LLMs so zu optimieren , dass sie die subtilen Nuancen menschlicher Kommunikation erfassen. Dabei geht es darum, Sprachmodelle nicht nur menschliche Interaktionen nachahmen zu lassen, sondern sie auch zu verstehen und sich an sie anzupassen. Durch die direkte Integration menschlichen Feedbacks in den Lernprozess zielt RLHF darauf ab, Interaktionen mit KI so natürlich und intuitiv zu gestalten wie das Gespräch mit einer anderen Person. In diesem Blogbeitrag tauchen wir in die Grundlagen von RLHF ein, sehen, wie es funktioniert, erkunden Tools und entdecken alternative Methoden zu dieser Methode.

Was ist RLHF?

Reinforcement Learning mit menschlichem Feedback (RLHF) ist eine Technik, bei der sich KI verbessert, indem sie direkt aus menschlichem Feedback lernt. Auf diese Weise bereichern Sie den Lernprozess der KI mit echten menschlichen Erkenntnissen. Bei RLHF produziert die KI nicht nur das, was sie allein auf der Grundlage von Daten für das Beste hält, sondern berücksichtigt auch, was die Menschen tatsächlich nützlich oder relevant finden. RLHF ist besonders praktisch für Aufgaben der natürlichen Sprachverarbeitung, die eine menschliche Note erfordern, wie etwa das Erstellen von Inhalten, die uns wirklich ansprechen. Durch die Integration unseres Feedbacks können Sprachmodelle Ergebnisse liefern, die mit menschlichen Zielen und Vorlieben übereinstimmen, was einen bedeutenden Fortschritt bei generativen KI-Anwendungen, einschließlich großer Sprachmodelle, darstellt.

Die Bedeutung von RLHF verstehen

Stellen Sie sich Folgendes vor: Sie optimieren ein Sprachmodell, um Text zusammenzufassen. Nehmen Sie diesen kurzen Text als Beispiel: „Das Internet hat die Art und Weise, wie wir Informationen teilen, revolutioniert und sie weltweit sofort verfügbar gemacht. Es ist zu einem entscheidenden Instrument für Kommunikation, Bildung und Unterhaltung geworden.“ Hier sind zwei verschiedene Zusammenfassungen des vorherigen Textes.

Zusammenfassung 1: „Das Internet hat die Kommunikation verändert, indem es den Informationsaustausch sofort und global ermöglicht.“

Zusammenfassung 2: „Das Internet hat unter anderem Auswirkungen auf die Kommunikation, die Verbesserung der Bildung und die Bereitstellung von Unterhaltung auf der ganzen Welt.“

Beide Zusammenfassungen erfassen zwar das Wesentliche, konzentrieren sich jedoch auf unterschiedliche Aspekte. Die erste ist prägnant und betont die Revolution in der Kommunikation. Die zweite geht auf die umfassenderen Auswirkungen des Internets ein und berührt Bildung und Unterhaltung. Welche „besser“ ist, hängt davon ab, auf welche Details und welchen Schwerpunkt wir mehr Wert legen.

Angesichts der Vielfalt von Sprache und menschlicher Wahl ist es klar, dass die Präferenzen für Zusammenfassungen von Person zu Person sehr unterschiedlich sein können. Diese Variabilität ist genau der Grund, warum Zusammenfassungen keine Einheitsaufgabe sind. Während bestimmte Aufgaben der natürlichen Sprachverarbeitung einfache Antworten haben, sind Zusammenfassungen subjektiv und führen oft zu mehreren „richtigen“ Zusammenfassungen, die auf individuellen Präferenzen basieren. Durch das Sammeln von menschlichem Feedback erstellt das RLHF-Modell die Daten, die für die spätere LLM-Verarbeitung erforderlich sind.

RLHF kann auch dann nützlich sein, wenn Sie ein LLM nicht von Grund auf neu trainieren. Angenommen, Sie erstellen eine Anwendung, deren Werte Sie festlegen möchten. Feinabstimmung ist zwar eine Möglichkeit, dies zu tun, manchmal ist RLHF jedoch die bessere Lösung. Auf eine Frage wie „Wo ist der Times Square?“ kann LLM einfach „New York“ oder „Der Times Square ist in New York“ antworten. Einige dieser Antworten werden sich natürlicher anfühlen als andere, daher ist RLHF eine Methode zum Sammeln von menschlichem Feedback darüber, welche Antworten sie bevorzugen, um ein Modell zu trainieren, damit es Antworten generiert, die von Menschen bevorzugt werden.

Und es geht nicht nur um die Zusammenfassung – viele LLM-Anwendungen erfordern unterschiedliche Meinungen, um umfassende Daten zu sammeln. Reinforcement Learning aus menschlichem Feedback ist hierfür die Lösung.

Kurz gesagt hilft uns RLHF dabei, die Fähigkeit von LLM zu verbessern, komplexe Aufgaben zu lösen, bei denen das gewünschte Ergebnis schwer zu erklären oder zu beschreiben ist. Mit anderen Worten: Probleme ohne eine einzige richtige Antwort, was bei vielen LLM-Problemen der Fall ist. RLHF löst zwar nicht alle Probleme der Wahrhaftigkeit und Toxizität in Sprachmodellen, aber es war ein wichtiger Beitrag zur Verbesserung der Qualität von LLM.

RLHF-Ansätze

Das erste, was Sie für RLHF tun, ist, Textbeispiele zu sammeln und sie von anderen zusammenfassen zu lassen. Es gibt selten nur eine Möglichkeit, einen Text zusammenzufassen, um die persönliche Note widerzuspiegeln, die Sprache von Natur aus hat.

Um dies zu erreichen, konzentrieren wir uns darauf zu verstehen, was den Leuten wirklich gefällt. Indem wir den Beschriftern zwei verschiedene Zusammenfassungen zeigen und sie fragen, welche sie bevorzugen, kommen wir von der Suche nach einer einzigen „richtigen“ Antwort dazu, die KI-Ausgaben an menschlicher Anleitung auszurichten. Dieser Ansatz ist der Schlüssel zum bestärkenden Lernen mit menschlichem Feedback (RLHF). Die Modellvergleichsvorlage von SuperAnnotate (eine unserer vielen LLM-Vorlagen ) konzentriert sich genau darauf. Wir bieten eine Datenerfassungspipeline zur Feinabstimmung eines Sprachmodells, indem unsere Experten oder Beschrifter verschiedene Modellausgaben vergleichen und die bevorzugten auswählen. Anstelle der traditionellen Modellabstimmung wird dieser Prozess als bestärkendes Lernen bezeichnet, das unsere KI anleitet, Ausgaben zu produzieren, die besser dem entsprechen, was die Leute sehen oder hören möchten.

Bei diesem Prozess beginnen Sie mit einem LLM, das bereits mit Anweisungen trainiert wurde und gelernt hat, diese zu befolgen. Anschließend sammeln Sie einen Datensatz, der die Präferenzen eines menschlichen Beschrifters bei mehreren Vervollständigungen derselben Eingabeaufforderungen angibt, und verwenden diesen Datensatz als Belohnungssignal, um ein auf Anweisungen abgestimmtes LLM zu optimieren. Das Ergebnis ist ein abgestimmtes LLM, das Ergebnisse generiert, die besser mit der menschlichen Anleitung übereinstimmen.

Wie funktioniert RLHF

RLHF ist ein sich entwickelnder Forschungsbereich und es gibt viele Variationen, wie wir es implementieren können, aber die übergeordneten Themen sind dieselben. RLHF besteht aus drei Phasen: Zuerst erstellen wir einen Präferenzdatensatz. Dann verwenden wir diesen Präferenzdatensatz, um eine Belohnungsfunktion mit überwachtem Lernen zu trainieren. Danach verwenden wir das Belohnungslernen in der Verstärkungslernschleife, um unser Basis-LLM zu optimieren.

RLHF-Phasen

Hier sind die RLHF-Phasen im Detail:

Phase 1: Präferenzdatensatz

Wir beginnen mit der Auswahl des Large Language Model (LLM), das verfeinert werden muss. Der Prozess beginnt damit, dem vorab trainierten Modell verschiedene Eingabeaufforderungen zu geben, z. B. Aufforderungen, bestimmte Texte zusammenzufassen, und so die Grundlage für weitere Feinabstimmungen zu schaffen. Menschliche Beschrifter spielen an dieser Stelle eine entscheidende Rolle; sie bewerten Paare von vom Modell generierten Antworten auf jede Eingabeaufforderung und wählen die passendere Option aus. Dieser Vergleich erstellt unseren Präferenzdatensatz, der menschliche Präferenzen unter den Ausgaben des Modells erfasst. Die Erstellung dieses Datensatzes ist wichtig, erfordert aber klare Ziele für die Feinabstimmung des Modells, wie z. B. die Verbesserung der Genauigkeit, die Reduzierung von Verzerrungen oder die Erhöhung des Benutzerengagements.

Stufe 2: Belohnungsmodell

Als Nächstes nehmen wir die Präferenzdaten, die wir gesammelt haben, und beginnen mit dem Training eines Belohnungsmodells . Die Aufgabe dieses Modells besteht im Wesentlichen darin, während des Trainingsprozesses als Richter zu fungieren und die Antworten des LLM mithilfe einer Belohnungsfunktion zu bewerten, die darauf basiert, wie gut sie mit den Präferenzen unserer menschlichen Beschrifter übereinstimmen. Dieser Schritt wandelt qualitative Urteile in quantifizierbare Bewertungen um und bietet eine Möglichkeit zu messen, wie nahe die Antwort eines LLM am Ideal liegt.

Beim Training dieses Modells werden ihm Beispiele von Eingabeaufforderungen mit zwei unterschiedlichen Antworten zugeführt – die bevorzugte und die weniger bevorzugte. Auf diese Weise lernt es, Bewertungen zu vergeben, die die Präferenzen widerspiegeln, mit denen es trainiert wurde. Bei der Bewertung der Belohnungsfunktion geht es nicht um richtig oder falsch, sondern darum, sich stärker an menschlichen Werten und Präferenzen auszurichten.

Phase 3: Feinabstimmung

Im letzten Schritt wird das Basissprachenmodell mit den Erkenntnissen aus dem Belohnungsmodell feinabgestimmt. Ziel ist es, die Ausgabe des LLM so anzupassen, dass sie menschliche Vorlieben besser widerspiegelt, was durch höhere Punktzahlen im Belohnungsmodell angezeigt wird.

In diesem Schritt wird ein anderer, mit Eingabeaufforderungen gefüllter Datensatz verwendet. Durch die Anwendung von Verstärkungslernen wird die Ausgabe des Modells verbessert und es in die Richtung gelenkt, Antworten zu generieren, die von Menschen bevorzugt werden.

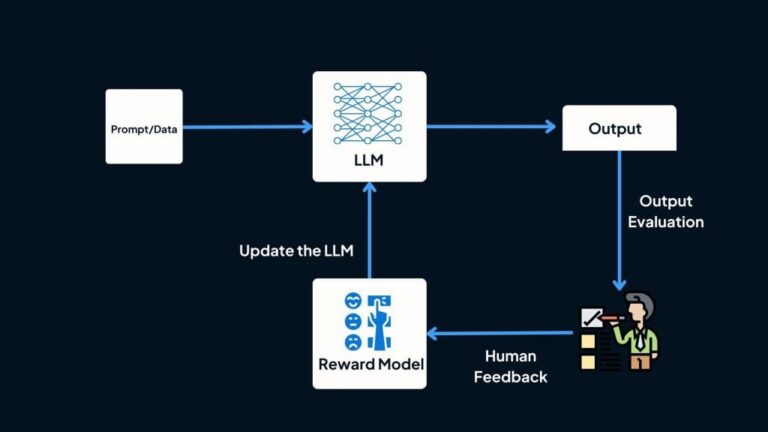

Und hier ist ein Diagramm, das den gesamten RLHF-Lebenszyklus zeigt:

Komponente des bestärkenden Lernens

Reinforcement Learning (RL) kommt ins Spiel, wenn Sie eine komplexe und nicht streng definierte Aufgabe haben. Stellen Sie sich vor, Sie versuchen, jemandem ein Spiel beizubringen, ohne ihm die Regeln explizit zu erklären, sondern ihn stattdessen für gute Züge zu belohnen. Das ist die Essenz von RL – es geht darum, das Modell dazu zu bringen, eine Reihe von Entscheidungen zu treffen, die zum besten Ergebnis führen, selbst wenn das „Beste“ nicht von Anfang an klar definiert ist.

Beim bestärkenden Lernen lernt das Modell oder der „Agent“ durch Handeln. Es interagiert mit seiner Umgebung, trifft Entscheidungen (oder „Aktionen“), beobachtet, wie die Umgebung reagiert, und erhält Belohnungen oder Strafen. Dieser Prozess hilft dem Agenten, die Regeln der Umgebung herauszufinden. Ein berühmtes Beispiel ist AlphaGo , das das Spiel Go meisterte, indem es mit verschiedenen Strategien experimentierte und aus den Ergebnissen lernte.

Dieser Lernprozess unterscheidet sich von dem, was wir beim überwachten Lernen sehen, bei dem das Modell anhand klarer Beispiele lernt, was zu tun ist. Beim bestärkenden Lernen gibt es keinen festgelegten Pfad. Der Agent erkundet, probiert verschiedene Aktionen aus und lernt aus den Ergebnissen. Er verfolgt, welche Aktionen in verschiedenen Situationen zu besseren Belohnungen führen, und speichert diese Informationen in einer Richtlinie. Wie das Entscheidungshirn des Agenten ordnet diese Richtlinie den aktuellen Zustand der Umgebung den Aktionen zu, die der Agent als Nächstes ausführen sollte, um die Belohnungen zu maximieren.

Wenn Sie beispielsweise ein großes Sprachmodell mit RL optimieren, kann der „aktuelle Status“ die Eingabeaufforderung enthalten, die dem Modell gegeben wurde, sowie jeden Text, den es bis zu diesem Zeitpunkt generiert hat. Die „Aktionen“ sind die nächsten Token oder Wörter, die das Modell generiert. Jede Entscheidung des Modells wird von einem Belohnungsmodell bewertet, das bewertet, wie gut der generierte Text mit dem übereinstimmt, wonach wir suchen. Das Ziel besteht darin, eine Richtlinie zu erlernen, die das LLM dazu bringt, hoch bewertete Vervollständigungen zu produzieren und dem Modell effektiv beizubringen, Text zu generieren, der den menschlichen Vorlieben besser entspricht.

RLHF in SuperAnnotate

Der LLM-Spielplatz von SuperAnnotate bietet vorgefertigte Vorlagen zum Erstellen von Datensätzen auf der Grundlage von menschlichem Feedback. RLHF ist ein wichtiger Teil dieses Prozesses, bei dem unsere Experten Daten entsprechend ihrem Fachwissen und ihren Präferenzen kennzeichnen und einen Datensatz erstellen, der für die Feinabstimmung durch RLHF bereit ist.

Hier sind einige Gründe, warum Unternehmen bei ihren RLHF-Sprachmodellprojekten auf SuperAnnotate vertrauen:

- Wir haben viel Zeit und Mühe investiert, um ein erstklassiges Expertenteam zusammenzustellen, das sorgfältig mit den Daten unserer Kunden arbeitet. Sie sorgen für erstklassiges menschliches Feedback – das Juwel für jedes RLHF-Projekt.

- Die Benutzeroberfläche ist vollständig anpassbar – Sie können neben den vorgefertigten Vorlagen Ihren eigenen Anwendungsfall erstellen !

- Unsere Plattform bietet Analysen und Einblicke, die es den Kunden ermöglichen, ihre Daten vollständig zu kontrollieren und zu verstehen.

- API-Integrationen erleichtern die Einrichtung eines Modells im Loop, KI-Feedback und vieles mehr.

Alternativen zu RLHF

Während Reinforcement Learning aus menschlichem Feedback eine robuste Methode bietet, um LLM-Ergebnisse an menschliche Präferenzen anzupassen, ist es nicht die einzige Methode, die in Frage kommt. Tatsächlich hat es einige bemerkenswerte Nachteile, die die Leute nach effizienteren Alternativen suchen lassen. Einige Herausforderungen sind die Skalierbarkeit der Erfassung menschlichen Feedbacks, potenzielle Verzerrungen durch die Feedback-Anbieter und die Komplexität der effektiven Integration dieses Feedbacks in den KI-Trainingsprozess. Lassen Sie uns ein paar RLHF-Alternativen näher betrachten und sehen, ob und wie sie diese Probleme lösen.

RLHF gegen DPO

RLHF ist ein komplizierter Prozess. Sie passen zunächst ein Belohnungsmodell auf der Grundlage von menschlichem Feedback an und optimieren dann das unüberwachte Sprachmodell mithilfe von RL, um den Belohnungswert zu maximieren und dabei nahe an der ursprünglichen Methode zu bleiben. Forscher der Stanford University haben kürzlich eine neue Parametrisierungsmethode für das Belohnungsmodell entwickelt, die eine optimale Richtlinienextraktion in geschlossener Form ermöglicht. Dadurch lässt sich das RLHF-Problem mit nur einem einfachen Klassifizierungsverlust lösen. Der resultierende Algorithmus heißt DPO und ist rechnerisch leicht, stabil und leistungsstark. DPO macht die Sampling-Ermittlung aus dem Sprachmodell während der Feinabstimmung oder der Durchführung einer signifikanten Hyperparameterabstimmung überflüssig.

DPO zeigt einige beeindruckende Ergebnisse und etabliert sich als Methode, die ein LM so fein abstimmt, dass es menschlichem Feedback genauso gut oder sogar besser entspricht als bestehende Methoden. Die Ergebnisse zeigen, dass DPO bei der Kontrolle der Stimmung von Generationen besser abschneidet als PPO-basiertes RLHF. Bei Zusammenfassungs- und Single-Return-Dialogaufgaben entspricht es RLHF oder verbessert es sogar, während es wesentlich einfacher zu implementieren und zu trainieren ist.

RLHF gegen RLAIF

Menschliche Arbeit beim RLHF-Training ist zeitaufwändig und umfangreich. Das ist ein wesentlicher Grund für eine Technik, die im letzten Jahr an Popularität gewonnen hat – RLAIF , das ein vorgefertigtes LLM verwendet, um die Arbeit menschlicher Annotatoren nachzuahmen und stattdessen KI-generierte Präferenzen zu erstellen.

Wenn es um Aufgaben wie Zusammenfassung und die Erstellung hilfreicher oder nicht anstößiger Dialoge geht, kann RLAIF mit RLHF mithalten und ist ihm manchmal sogar voraus. Es übertrifft den Standardansatz der Feinabstimmung mit Überwachung und tut dies eindrucksvoll mit einem Präferenzlabeler, der dieselbe Größe hat wie das Richtlinienmodell, das es trainiert mixtral.

Interessanterweise kann es zu besseren Ergebnissen führen, wenn man das LLM direkt nach Belohnungswerten fragt, als der typische RLAIF-Ansatz, bei dem die vom LLM generierten Präferenzen zunächst in ein Belohnungsmodell umgewandelt werden. Durch die gründliche Erforschung verschiedener Methoden zur Generierung von KI-Präferenzen, die mit menschlichen Werten übereinstimmen, deuten die Ergebnisse darauf hin, dass RLAIF in der Lage ist, menschliche Annotatoren zu übertreffen. Dieser Durchbruch weist auf einen Weg, das heikle Problem der Skalierung von RLHF zu umgehen, und bietet einen Blick in eine Zukunft, in der die Anpassung der KI an menschliche Präferenzen vielleicht doch nicht so entmutigend ist.

Detailliertes menschliches Feedback

Sprachmodelle machen manchmal Fehler, indem sie Inhalte erstellen, die irreführend, schädlich oder einfach irrelevant sind. Um diese Modelle zu besseren Zuhörern und Sprechern zu machen, haben Forscher unser bekanntes RLHF implementiert.

Aber das traditionelle RLHF ist, als ob man ein einziges Zeugnis für die Fächer eines ganzen Jahres erhält – es ist zu allgemein gehalten und zeigt nicht auf, wo das Modell verbessert werden muss. Das feinkörnige RLHF ist ein ausgefeilter Ansatz, der das Feedback in detailliertere, mundgerechte Häppchen aufteilt. Es ist, als ob man ein Zeugnis erhält, das einem nicht nur sagt, wie man in jedem Fach abgeschnitten hat, sondern einem auch Feedback zu jeder Aufgabe und jedem Test gibt.

Feinkörniges RLHF ermöglicht Training und Lernen mit Belohnungsfunktionen, die in zweierlei Hinsicht feinkörnig sind:

- Dichte: Bereitstellung einer Belohnung nach der Generierung jedes Segments (z. B. eines Satzes).

- Einbeziehung mehrerer Belohnungsmodelle im Zusammenhang mit unterschiedlichen Feedback-Typen (z. B. sachliche Unrichtigkeit, Irrelevanz und unvollständige Informationen).

Sie können alle zugehörigen Daten, das gesammelte menschliche Feedback und die Codes auf GitHub finden .

Einpacken

Die Einführung von Sprachmodellen wie GPT-3 eröffnete eine Welt voller Möglichkeiten, KI dazu zu bringen, menschenähnliche Sprache zu verstehen und zu generieren. Aber hier liegt die wahre Herausforderung: die KI so zu optimieren, dass sie die Nuancen dessen erfasst, was wir wirklich meinen oder bevorzugen. RLHF kommt hier ins Spiel und kombiniert die besten Lernfähigkeiten von LLM mit den unersetzlichen Erkenntnissen aus menschlichem Feedback. Es geht darum, KI nicht nur intelligent, sondern auch sensibel für unsere Vorlieben zu machen.

RLHF glänzt, indem es KI in Richtung von Ergebnissen lenkt, die bei uns authentischer ankommen, insbesondere in Szenarien ohne eindeutige Antworten. Die Perfektionierung dieses Ansatzes ist jedoch mit Hürden verbunden, beispielsweise muss sichergestellt werden, dass wir skalieren können, ohne die persönliche Note zu verlieren oder Verzerrungen einzuführen. Aus diesem Grund erhalten Alternativen wie die direkte Leistungsoptimierung (DPO) und das bestärkende Lernen aus KI-Feedback (RLAIF) Aufmerksamkeit. DPO vereinfacht den Feinabstimmungsprozess und RLAIF führt eine clevere Problemumgehung für die Skalierbarkeitsherausforderung von RLHF ein, indem KI zur Simulation menschlichen Feedbacks verwendet wird. Beide zeigen vielversprechende Fortschritte bei der Erzielung nuancierter KI-Interaktionen.

Während wir diese Wege erkunden, ist das Endziel kristallklar: die Entwicklung künstlicher Intelligenzsysteme, die nicht nur effizient sind, sondern auch tief mit menschlichen Werten und Gedanken im Einklang stehen. Die Reise von RLHF und ihre Alternativen zeigen unseren Antrieb, KI zu schaffen, die uns wirklich versteht und auf menschlicher Ebene mit uns interagiert. Es ist eine aufregende Zeit, und jeder Schritt nach vorne bringt uns einer nahtlos integrierten KI-Mensch-Interaktion näher.